|

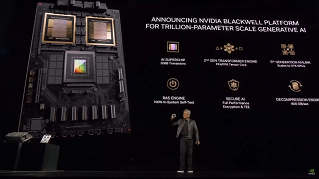

El nuevo “superchip” de Nvidia para

entrenar IA es un paso gigante en la industria

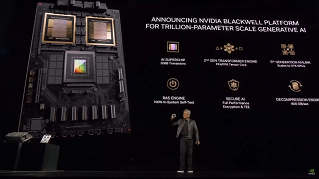

Esta semana, Nvidia ha presentado el chip Blackwell B200, la GPU de

un solo chip más poderosa de la compañía, con 208 mil millones de

transistores, que podría reducir los costos operativos de inferencia

de inteligencia artificial (IA), tales como ejecutar ChatGPT, así

como el consumo de energía hasta 25 veces en comparación al H100. La

compañía también presentó el GB200, un "superchip" que combina dos

chips B200 y una CPU Grace para lograr un rendimiento aún mayor.

Nvidia promete que el GB200 proporciona un aumento de rendimiento de

hasta 30 veces en comparación con su GPU más poderosa en el mercado.

La noticia se dio a conocer en el marco de la conferencia anual GTC

de Nvidia, que se lleva a cabo esta semana en el Centro de

Convenciones de San José. El director ejecutivo de Nvidia, Jensen

Huang, pronunció el discurso de apertura el lunes por la tarde.

"Necesitamos GPU más grandes", dijo. La plataforma Blackwell

permitirá el entrenamiento de modelos de IA de billones de

parámetros que harán que los modelos de IA generativos actuales

parezcan rudimentarios en comparación, dijo. Como referencia, el GPT-3

de OpenAI, lanzado en 2020, incluía 175 mil millones de parámetros.

El recuento de parámetros es un indicador aproximado de la

complejidad de los modelos de IA.

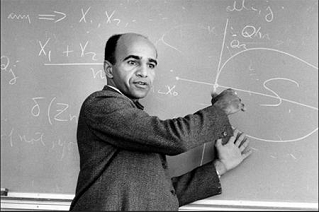

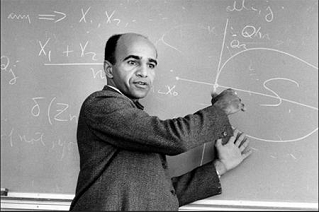

Nvidia nombró la arquitectura Blackwell en honor a David Harold

Blackwell, un

matemático que se especializó en teoría de juegos y estadística y

que fue el primer académico negro incluido en la Academia Nacional

de Ciencias. La plataforma presenta seis tecnologías para

computación acelerada, incluido un transformador de segunda

generación, el protocolo NVLink de quinta generación, motor RAS,

capacidades de

|

|

seguridad para IA y un motor de

descompresión para consultas aceleradas de bases de datos.

Se espera que varias organizaciones importantes, como Amazon Web Services (AWS),

Dell, Google, Meta, Microsoft, OpenAI, Oracle, Tesla y xAI, adopten la

plataforma Blackwell. El comunicado de prensa de Nvidia está repleto de citas

enlatadas de directores ejecutivos de tecnología (que son también clientes clave

de Nvidia) como Mark Zuckerberg y Sam Altman elogiando la plataforma.

Las GPU, que antes solo estaban diseñadas para la aceleración de juegos, son

especialmente adecuadas para tareas de IA porque su arquitectura, diseñada para

tareas en paralelo, acelera la inmensa cantidad de multiplicaciones de matrices

necesarias para ejecutar las redes neuronales actuales. Con el surgimiento de

nuevas arquitecturas de aprendizaje profundo en la década de 2010, Nvidia se

encontró en una posición ideal para capitalizar la revolución de la IA y comenzó

a diseñar GPU especializadas para la tarea de

acelerar los modelos de IA.

El enfoque de Nvidia en el centro de datos ha hecho que la empresa sea

extraordinariamente rica, y estos nuevos chips prometen ayudar a que continúe la

tendencia. Los ingresos por la venta de GPU de Nvidia dedicados a los juegos

(2,900 millones de dólares en el último trimestre) son eclipsados en

comparación con

los ingresos del centro de datos

(18.400 millones de dólares).

Una bestia dentro de una bestia

El “superchip” Grace Blackwell GB200 antes mencionado llega como parte clave del

nuevo NVIDIA GB200 NVL72, un sistema informático de centro de datos de múltiples

nodos y refrigeración líquida

|

|

diseñado

específicamente para tareas de inferencia y entrenamiento de IA. Combina 36

GB200 (es decir, 72 GPU B200 y 36 CPU Grace en total), interconectados por el

protocolo NVLink de quinta generación, que vincula chips para aumentar el

rendimiento.

"El GB200 NVL72 proporciona un aumento de rendimiento de hasta 30 veces en

comparación con la misma cantidad de GPU NVIDIA H100 Tensor Core para cargas de

trabajo de inferencia LLM y reduce el costo y el consumo de energía hasta 25

veces", dijo Nvidia.

Ese tipo de aceleración podría traducirse en ahorro de dinero y tiempo al

ejecutar los modelos de IA actuales, pero también permitirá construir modelos de

IA más complejos. Los modelos de IA generativa, como los que impulsan Google

Gemini y los generadores de imágenes de IA , son famosos por su “hambre”

computacional. Se ha citado ampliamente que la escasez de potencia informática

frena el progreso y la investigación en el campo de la IA, y la búsqueda de más

computación ha llevado a figuras como el director ejecutivo de OpenAI, Sam

Altman, a intentar negociar acuerdos para crear nuevas fábricas de chips.

Si bien las afirmaciones de Nvidia sobre las capacidades de la plataforma

Blackwell son significativas, vale la pena señalar que su rendimiento en el

mundo real y la adopción de la tecnología aún están por verse a medida que las

organizaciones comiencen a implementar y utilizar la plataforma por sí mismas.

Competidores como Intel y AMD también buscan hacerse con una parte del pastel de

IA de Nvidia. |